Missionl AI发布Mistral Small 3,仅 24B 参数,但性能可匹敌 70B 级别模型

作者:啊哈哈哈 来源:08论坛 时间:2025-03-19 14:47:46

Mistral ai于 2025 年 1 月 30 日发布了 Mistral Small 3,这是一个优化延迟的 24B 参数模型,旨在提供高效的性能。该模型在 Apache 2.0 许可下发布,允许用户自由使用和修改。

Mistral Small 3主要特点:

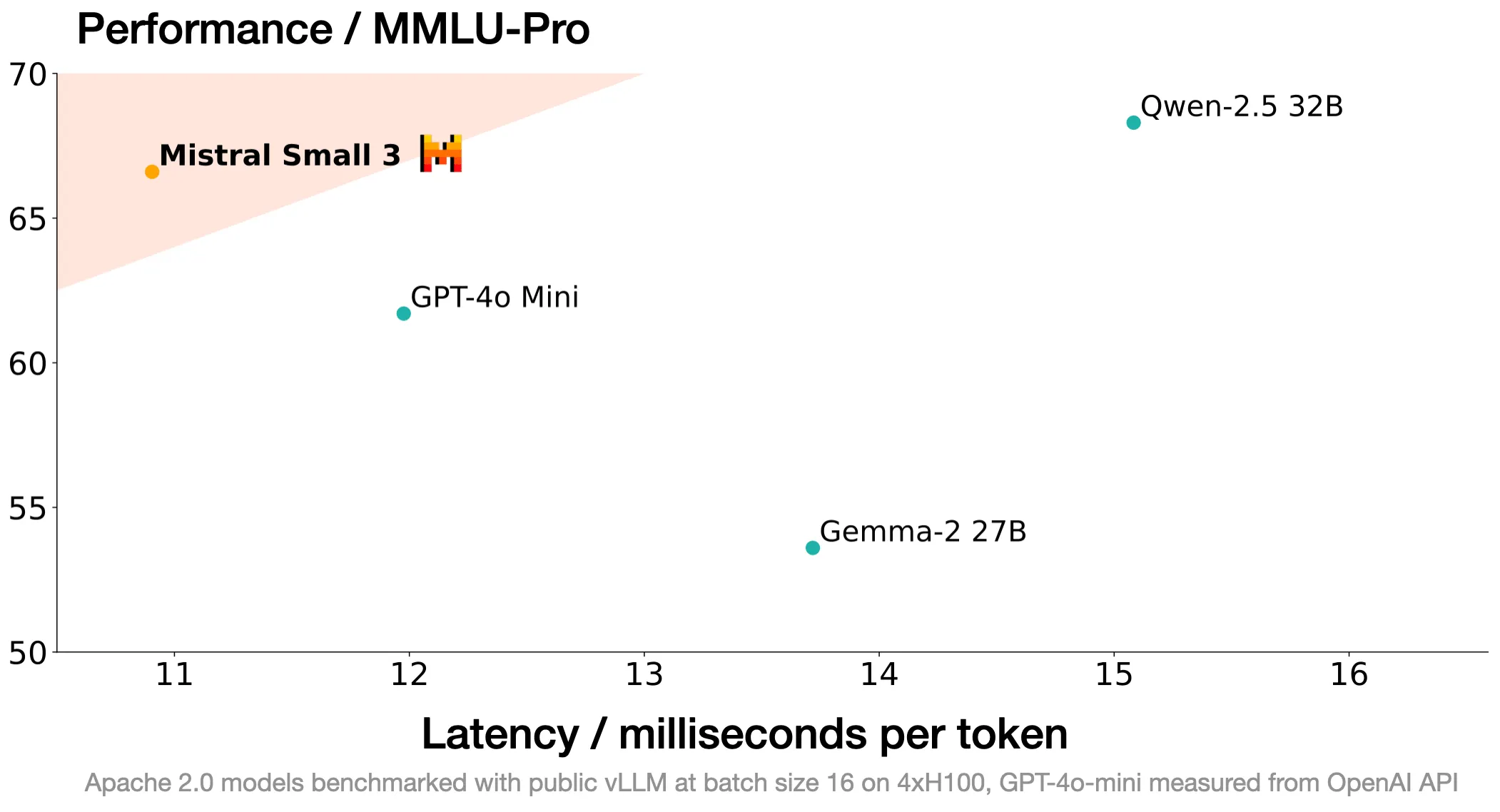

高性能与规模:尽管只有 24B 参数,Mistral Small 3 的性能可以与更大规模的模型(如 Llama 3.3 的 70B 参数模型)相媲美。这使得它在相同硬件上能够实现更快的推理速度。

延迟优化:Mistral Small 3 针对低延迟工作负载进行了优化,非常适合需要快速响应的应用场景。

领域专家微调:适用于法律、医疗、技术支持等领域的特定任务训练,提高专有知识的准确性。

本地推理:支持在 RTX 4090 或 MacBook 32GB RAM 上本地运行,适合 处理敏感或专有数据的个人与企业。

Mistral Small 3 的设计特别关注于满足大多数生成 AI 任务的需求,尤其是那些需要强大语言能力和指令跟随性能的任务。该模型在 MMLU 基准测试中达到了超过 81% 的准确率,并且在相同硬件上以每秒 150 个标记的速度运行,显示出其在效率方面的优势。

此外,Mistral Small 3 还被设计为适合本地部署,特别是在处理敏感或专有信息的场景中。用户可以在单个 RTX 4090 或 32GB RAM 的 Macbook 上运行该模型,进一步增强了其可用性和灵活性。

Mistral Small 3 还与多个平台合作,包括 Hugging Face、Ollama 和 Kaggle,使得开发者能够更方便地访问和使用该模型。

Mistral Small 3应用

Mistral Small 3 适用于多种应用,包括自然语言处理、对话系统和其他需要高效推理的任务。其设计目标是为开发者提供一个灵活且强大的工具,以满足现代 AI 应用的需求。

对话助手: 适用于需要快速、准确响应的虚拟助手。

函数调用: 能够快速执行自动化或代理工作流中的函数。

领域专家: 可微调以在特定领域中创建高精度的专家模型。

本地推理: 适合处理敏感或专有信息的本地推理。

金融服务:用于欺诈检测。

医疗行业:用于患者分诊和客户支持。

机器人/汽车/制造业:在设备端执行命令控制。

官方介绍:https://mistral.ai/news/mistral-small-3/

- 上一篇: 2025蛇年春节期间最新AI新闻

更多资讯

热门文章

推荐对话

换一换- 人气排行

- 1 Missionl AI发布Mistral Small 3,仅 24B 参数,但性能可匹敌 70B 级别模型

- 2 2025蛇年春节期间最新AI新闻

- 3 Gemini 2.0 Flash已在Google AI Studio和Vertex AI平台正式上线

- 4 OpenAI发布新的推理模型:O3-Mini和O3-Mini-High

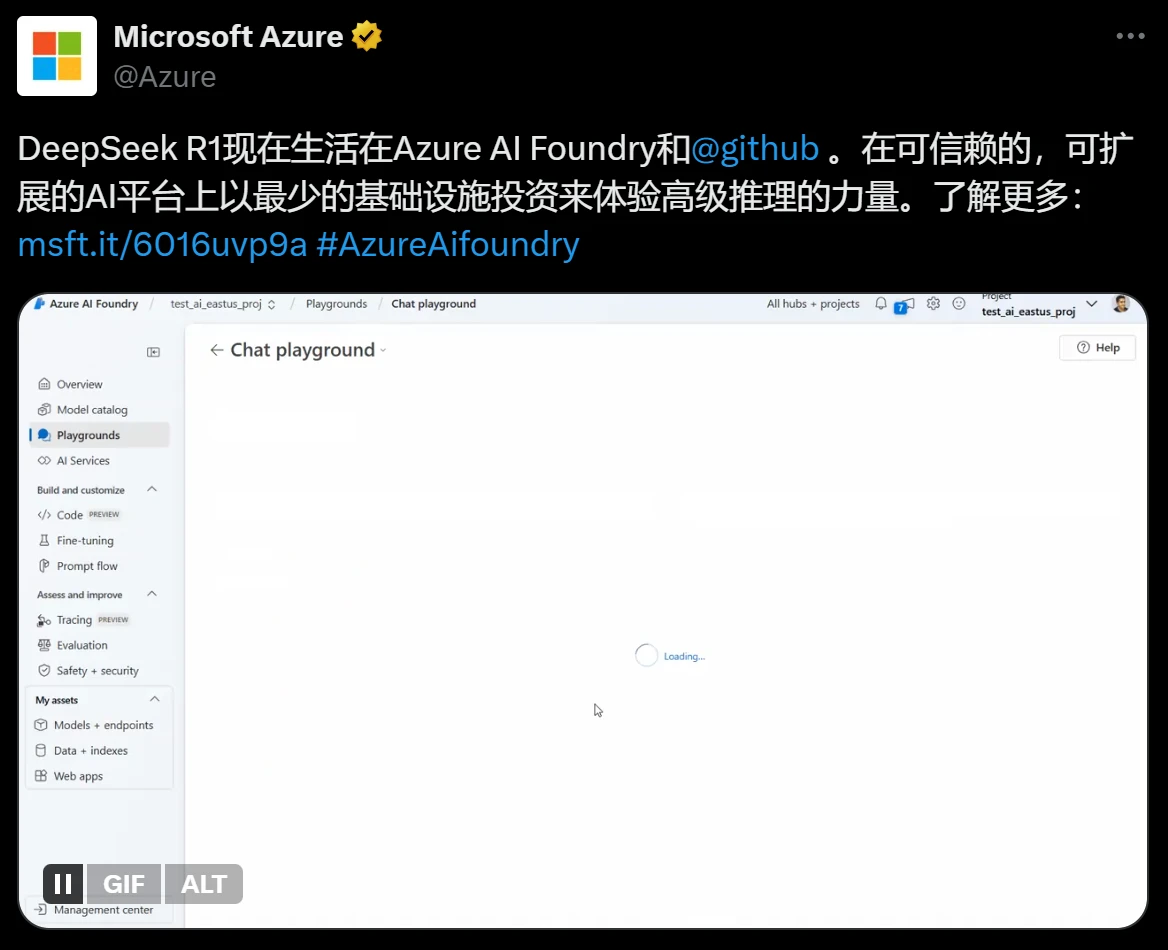

- 5 微软、亚马逊、英伟达等服务商宣称已接入Deepseek R1

- 6 Daily Listen:Google推出的根据兴趣生成定制的音频内容工具

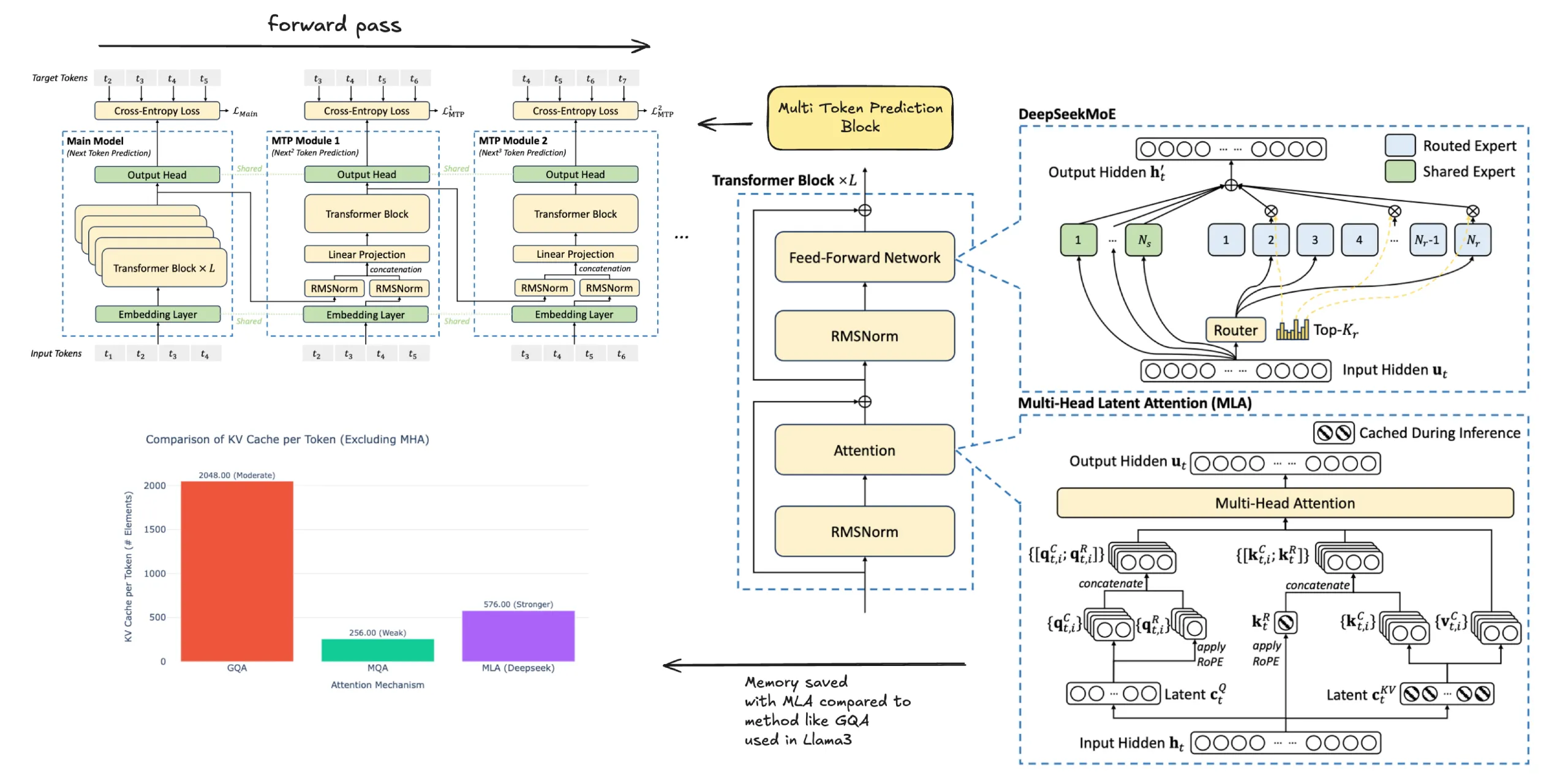

- 7 Open R1:DeepSeek-R1的完全开源再现项目

- 8 如何使用DeepSeek修改润色简历?

- 9 Deepseek的10条提问技巧

- 10 安装DeepSeek需要哪些配置,普通电脑可以吗?