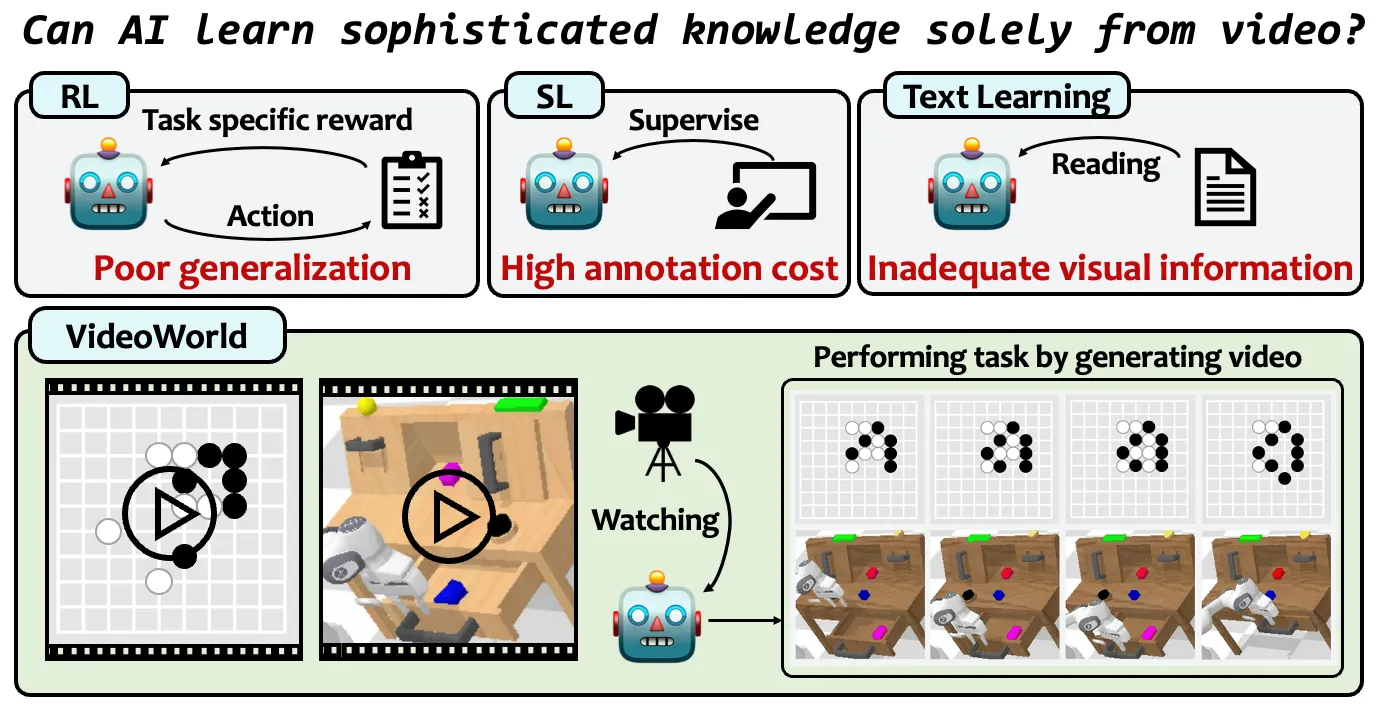

VideoWorld:无需依赖语言模型,只通过视觉就可实现复杂任务

作者:啊哈哈哈 来源:08论坛 时间:2025-03-14 15:41:01

2025年2月10日,视频生成模型“VideoWorld”由豆包大模型团队与北京交通大学、中国科学技术大学联合开发并正式开源,VideoWorld模型的核心创新在于它完全无需依赖语言模型,只通过视觉信息就可实现复杂任务的学习与生成。

一、核心功能特征

1. 纯视觉知识学习

通过无标注视频数据自主掌握复杂规则与策略(如围棋落子逻辑、机器人操作时序),无需语言指令或强化学习的奖励机制

支持多步骤推理与长期规划能力,例如围棋对弈中预判对手后续5-9步行动

2. 高效视觉表征压缩

引入潜在动态模型(LDM)将视频帧间变化编码为紧凑的潜在序列,降低冗余信息干扰

实现长短期动态依赖的联合建模,短时关注精细位移(如机械臂微调),长时捕捉任务级模式(如围棋战术组合)

3. 跨场景泛化能力

在CALVIN与RLBench机器人测试集上接近Oracle模型性能,可适应不同环境参数(如光照、物体位置)

围棋对弈达职业五段水平(Video-GoBench基准),超越传统强化学习代理。

二、VideoWorld技术架构:

基础架构

基于VQ-VAE将视频帧离散化为token序列,采用自回归Transformer实现帧级预测

训练数据仅包含任务执行过程视频(如围棋棋局演变、机械臂操作记录)

潜在动态模型(LDM)

编码机制:将未来H帧视觉变化压缩为连续潜在代码,量化后作为预测目标

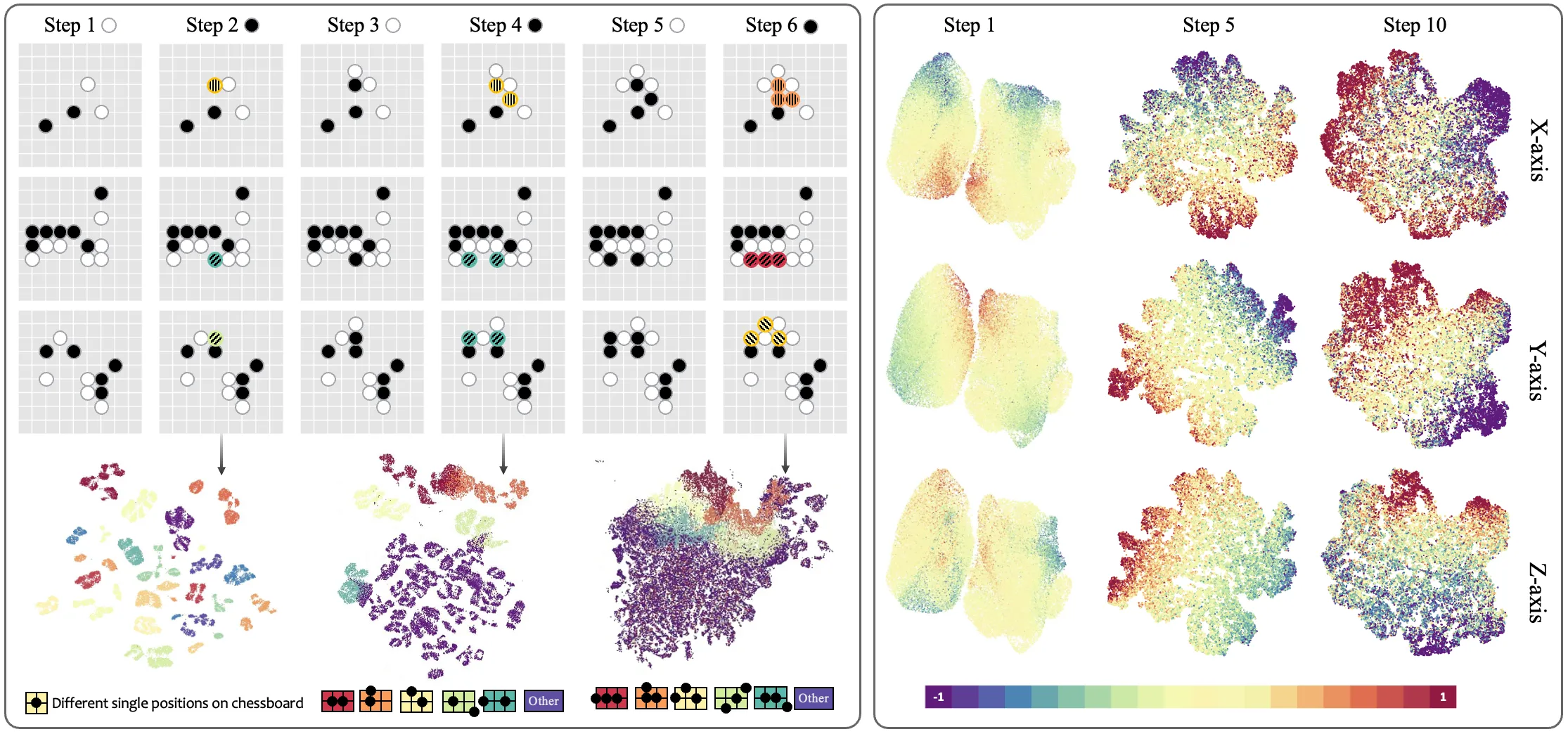

双流预测:联合优化视频帧生成与潜在代码预测,增强对关键决策节点的建模

可解释分析:通过UMAP可视化显示潜在空间聚类与任务动态强相关。

效率优化设计

模型参数量控制在3亿级,相比传统视频模型降低80%计算开销

训练数据规模:Video-GoBench包含十万级围棋对局视频帧

三、VideoWorld应用场景

内容创作:为短视频制作、电影场景构思、游戏中的视觉内容生成等提供强大的支持。

教育:通过生成动态视频,帮助学生更生动地理解复杂的知识。

广告:根据用户的偏好,生成个性化的广告视频,提升营销效果。

四、VideoWorld下载和安装:

1. 克隆仓库:

gitclonehttps://github.com/bytedance/VideoWorld.gitcdVideoWorld2. 安装依赖:

pipinstall-rrequirements.txt3. 运行示例:示例代码通常位于 examples 或 scripts 目录下。根据需要调整配置文件并运行相应的脚本。

五、VideoWorld项目页面:

项目主页:https://maverickren.github.io/VideoWorld.github.io

GitHub 地址: https://github.com/bytedance/VideoWorld

论文链接: https://arxiv.org/abs/2501.09781

更多资讯

热门文章

推荐对话

换一换- 人气排行

- 1 VideoWorld:无需依赖语言模型,只通过视觉就可实现复杂任务

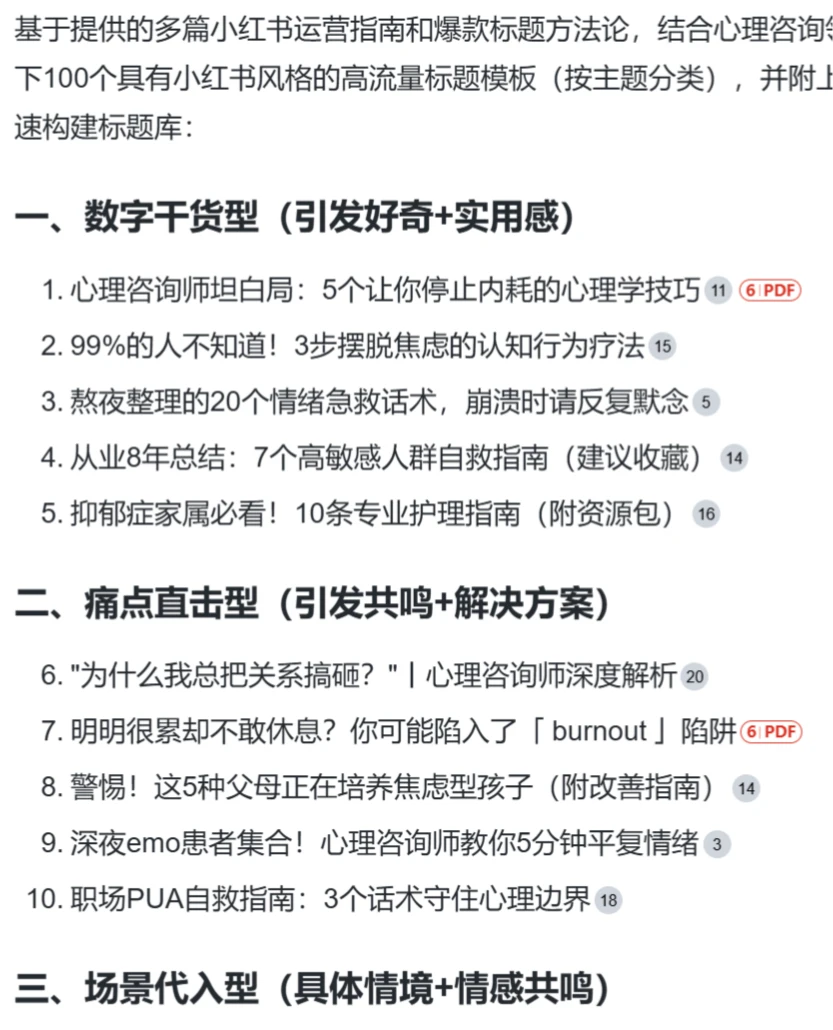

- 2 基于真实运营经验总结:新手怎么运营小红书赚钱方法

- 3 6大类30个实用Deepseek提示词模板

- 4 清华大学《DeepSeek+入门到精通》PDF下载

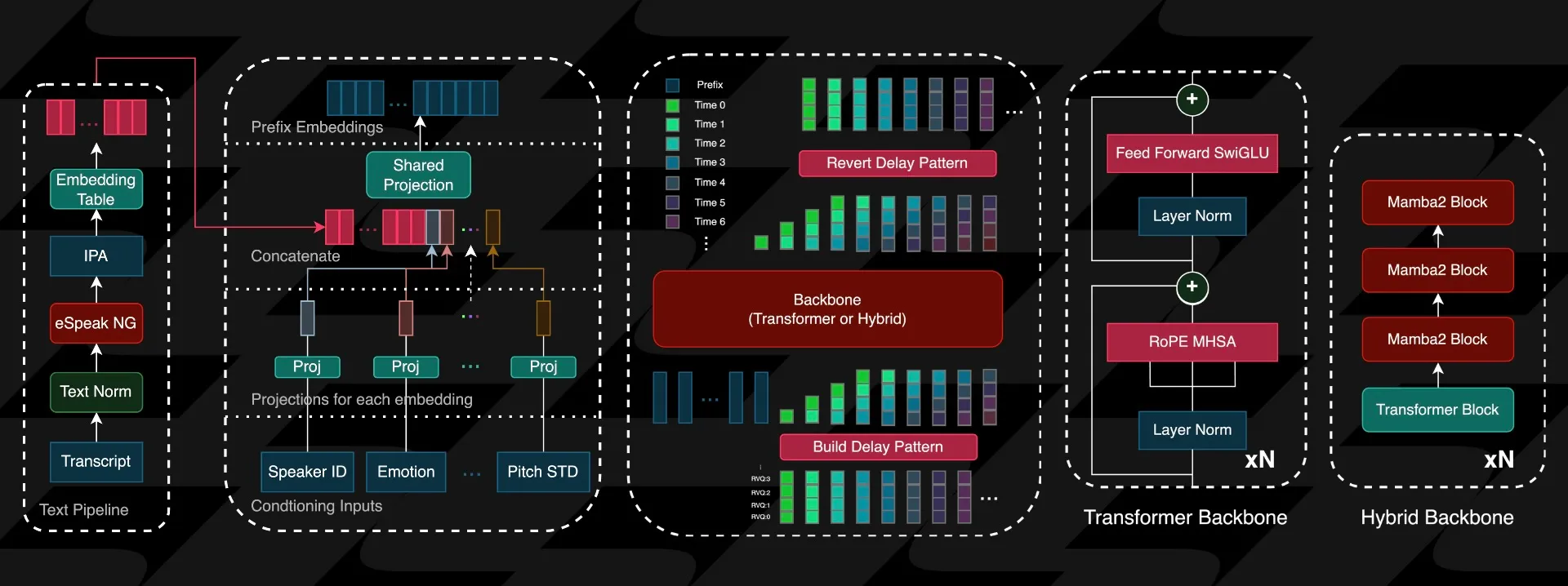

- 5 Zonos-TTS:多语言文本转语音模型,支持声音克隆与情感控制

- 6 学会这三点提问方式,让DeepSeek秒变"私人秘书"!

- 7 苹果公司正在与阿里巴巴合作,为中国的iPhone用户推出人工智能

- 8 Whisk:Google推出的新的“以图生图”图像生成工具

- 9 Cerebras与Perplexity联打造新的AI搜索模型:Sonar

- 10 零基础如何用DeepSeek做小红书等自媒体