UniTok:字节开源的一个同时用于生成和理解任务的视觉分词器

作者:啊哈哈哈 来源:08论坛 时间:2025-03-10 09:17:50

UniTok是什么?

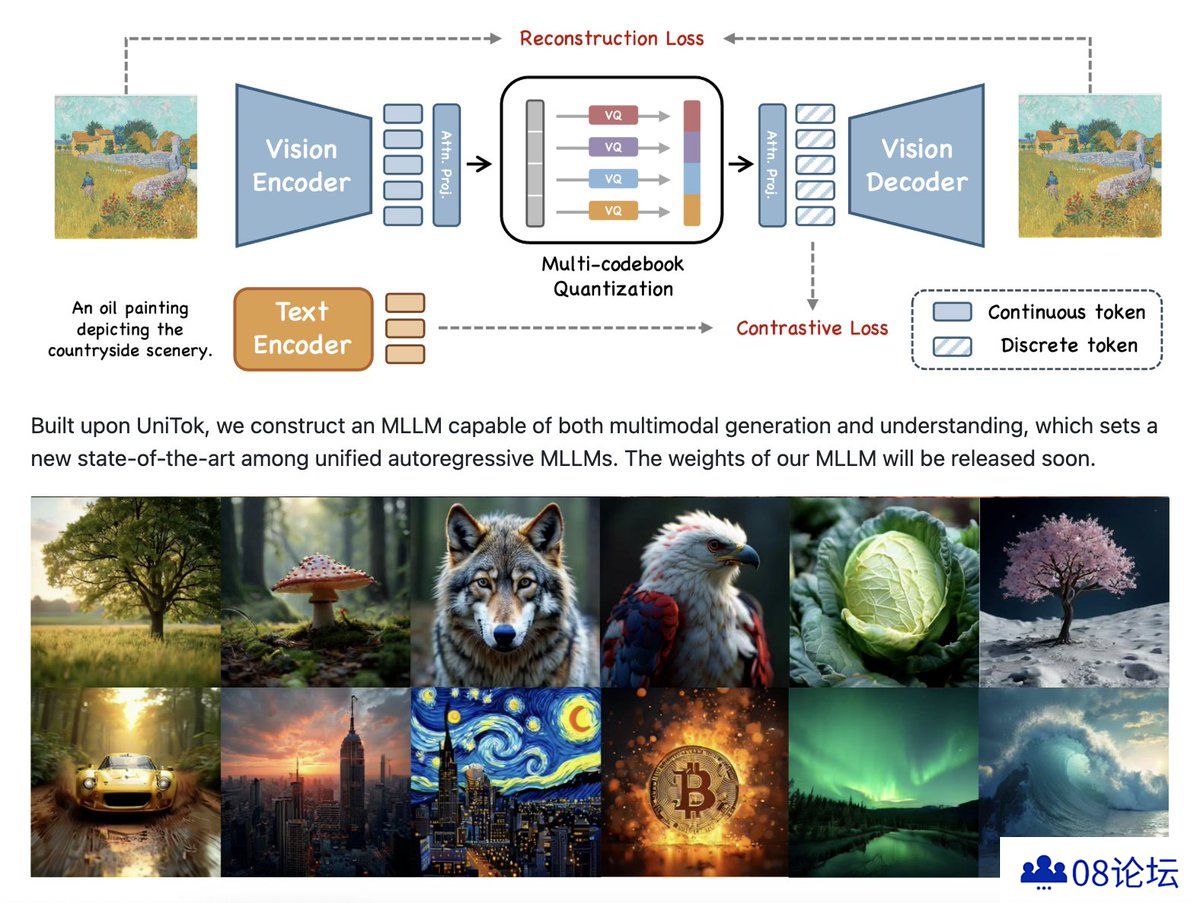

UniTok 是字节开源的一个同时用于生成和理解任务的视觉分词器,能够高效地将视觉信息转化为 token,适用于多种自回归生成模型和多模态理解模型。它通过创新的视觉分词技术,能够以极低的 token 数量(如 256 个 token)实现高质量的视觉内容生成,例如图像和视频的重建。

UniTok 的核心功能

高效视觉编码:UniTok 能够将复杂的视觉信息(如图像和视频)分解为离散的 token,便于模型处理。

多模态支持:它不仅适用于图像,还能处理视频内容,支持连续和离散分词化。

低资源需求:UniTok 在低 token 数量下仍能保持高重建质量,例如在 256 个 token 下的重建误差仅为 0.39。

灵活的压缩率:用户可以根据需求调整 token 数量,以平衡生成质量和计算效率。

UniTok应用领域

视觉生成任务:如图像和视频重建、语言模型驱动的视觉合成。

多模态理解:结合文本和视觉信息,实现更高效的多模态模型训练。

扩散模型:与 DiT 和 Latte 等扩散模型结合,生成高质量的视觉内容。

UniTok技术实现

UniTok 基于 VQVAE(变分量子化自编码器)和 VAE(变分自编码器)技术,通过两阶段训练实现高效的视觉编码。其训练过程包括:

图像单一分辨率训练:在固定分辨率上进行图像训练。

图像-视频联合多分辨率训练:在多个分辨率上进行图像和视频的联合训练。

VAE 微调:通过 KL 损失对 VQVAE 模型进行微调,得到 VAE 模型。

UniTok优势

单一模型和权重:UniTok 通过单一模型和权重处理图像和视频分词,简化了模型管理和部署。

高适应性:支持高分辨率和长视频输入,适应多种应用场景。

兼容性强:与语言模型和扩散模型兼容,实现多样化的视觉生成。

UniTok 通过多码本量化技术,解决了传统分词器在生成和理解任务中的瓶颈,为多模态大语言模型(MLLMs)提供了一个更高效的解决方案。

项目地址:https://foundationvision.github.io/UniTok/

GitHub仓库:https://github.com/FoundationVision/UniTok

更多资讯

热门文章

推荐对话

换一换- 人气排行

- 1 UniTok:字节开源的一个同时用于生成和理解任务的视觉分词器

- 2 英伟达被曝挖走小鹏智驾负责人:副总裁吴新宙,清华校友,NGP第一功臣

- 3 Waymo官方暴力突入指南:如何制服一辆完全自动驾驶故障车

- 4 沧州自动驾驶汽车试水商用,百度Apollo等将探索收费模式

- 5 百度首次披露自动驾驶营收,李彦宏:大招RoboTaxi盈利指日可待

- 6 马斯克确认:特斯拉新车没有刹车、踏板、方向盘

- 7 王传福「三哭」比亚迪:烧钱、被嘲笑、一度只求别死掉

- 8 英特尔发布CPU、傲腾硬盘、100G以太网:一切为了数据中心和AI

- 9 何小鹏官宣吴新宙离职,百度无人车元老接棒自动驾驶一号位

- 10 美女新难题:如何自证不是AI