OpenManus-RL:一个提升LLM智能体的推理与决策能力开源项目

作者:啊哈哈哈 来源:08论坛 时间:2025-04-16 15:54:56

OpenManus-RL是什么?

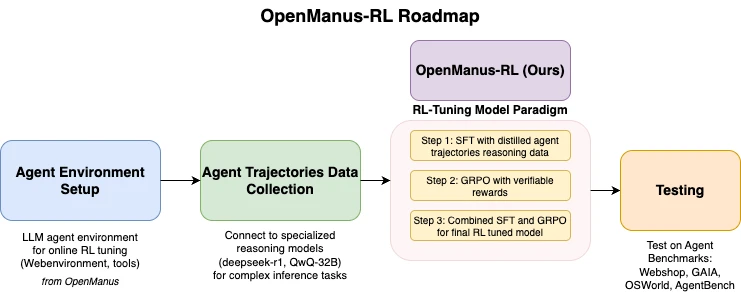

OpenManus-RL是一个由UIUC-Ulab与MetaGPT社区的OpenManus团队联合开发的开源项目,可以通过强化学习RL技术提升大型语言模型LLM智能体的推理与决策能力。该项目基于Deepseek-R1、QwQ-32B等先进模型的经验,探索新的调优方法,以增强智能体在复杂任务中的表现。 OpenManus-RL的核心功能包括智能体环境的搭建、轨迹数据的收集、强化学习调优支持以及基准测试的集成。它还集成了多种强化学习策略,如Tree-of-Thoughts和蒙特卡洛树搜索(Monte Carlo Tree Search),以提升智能体的推理能力。

OpenManus-RL功能特征

智能体环境搭建:提供在线强化学习(RL)调优的智能体环境配置工具,方便用户为特定任务定制智能体环境。

轨迹数据收集:能够连接Deepseek-R1、QwQ-32B等模型,收集复杂任务的行为数据,为后续的调优提供数据支持。

RL调优支持:支持定制化智能体行为的强化学习方法,用户可以通过指定奖励函数等方式对智能体的行为进行优化。

基准测试集成:内置WebShop、GaiA、OSWorld、AgentBench等测试环境,方便用户对智能体的性能进行量化评估。

多样化策略:集成Tree-of-Thoughts、Monte Carlo Tree Search等强化学习策略,提升智能体在长程规划任务中的推理能力。

社区协作:允许用户提交代码、数据集等,重要贡献者可成为论文共同作者,促进社区的共同开发。

实时进展分享:通过动态更新展示RL调优过程与成果,方便用户了解项目的最新进展。

OpenManus-RL应用场景

购物决策:通过定制智能体环境,优化智能体在购物决策任务中的表现,例如在WebShop中提升购买成功率。

复杂任务分析:分析智能体在复杂任务中的表现,如在GAIA、OSWorld等基准测试中的成功率、响应时间等指标,帮助开发者对比模型性能。

多模态任务优化:在OSWorld等多模态任务环境中,优化智能体的行为,提升其在多模态任务中的表现。

长程规划任务:利用集成的多样化策略,提升智能体在长程规划任务中的推理能力,例如通过Tree-of-Thoughts策略优化智能体的行为。

OpenManus-RL安装

1. 创建Conda环境:为避免依赖冲突,建议使用Conda创建环境,命令如下:

condacreate-nopenmanus-rlpython=3.10condaactivateopenmanus-rl2. 克隆项目:确保已安装Git,然后克隆项目并进入项目目录,命令如下:

gitclonehttps://github.com/OpenManus/OpenManus-RL.gitcdOpenManus-RL3. 安装依赖:在项目根目录执行以下命令安装依赖,若下载慢可使用国内镜像:

pipinstall-rrequirements.txt或

pipinstall-rrequirements.txt-ihttps://pypi.tuna.tsinghua.edu.cn/simple可视化工具需额外安装:

pipinstallmatplotlibnumpy4. 配置模型与数据集:

监督微调(SFT):指定模型和数据集,命令如下:

python-mopenmanus_rl.sft--model_name_or_pathQwen/Qwen2.5-1.5B-Instruct--dataset_nameCharlieDreemur/OpenManus-RL强化学习调优(GRPO):配置奖励函数,命令如下:

python-mopenmanus_rl.grpo--model_name_or_pathQwen/Qwen2.5-1.5B-Instruct--dataset_nameCharlieDreemur/OpenManus-RL-GRPO--reward_funcsaccuracyformattag_count数据集可从Huggingface获取。

5. 运行项目:

单GPU运行SFT:

python-mopenmanus_rl.sft--output_dirdata/sft-output多GPU运行GRPO(需配置zero3.yaml):

acceleratelaunch--config_file=configs/accelerate_configs/zero3.yamlopenmanus_rl/grpo.py--output_dirdata/grpo-outputOpenManus-RL使用

1. 智能体环境搭建:

运行python -m openmanus_rl.sft生成基础环境。

修改配置文件(如任务目标或奖励函数)。

执行python -m openmanus_rl.grpo开始调优。

2. 数据收集与测试:

配置模型(如Deepseek-R1):python -m openmanus_rl.grpo --model_name_or_path Deepseek-R1

运行测试:--benchmark GAIA,结果保存至data/目录。

3. RL调优操作:

运行GRPO模式:python -m openmanus_rl.grpo --reward_funcs accuracy

查看训练日志,模型保存至data/grpo-output。

GitHub仓库地址:https://github.com/OpenManus/OpenManus-RL

更多资讯

热门文章

推荐对话

换一换- 人气排行

- 1 OpenManus-RL:一个提升LLM智能体的推理与决策能力开源项目

- 2 DeepSeek R2或在3月17日发布,更好的编码、多语言推理、更低成本

- 3 老黄现场演示与游戏NPC聊天!大模型开口建议玩家去找犯罪头目,网友:西部世界成真

- 4 DeepSeek R2、Kimi K1.5、DeepSeek V3、DeepSeek R1与ChatGPT的比较分析

- 5 LanPaint:适用于Stable Diffusion模型的无需额外训练的高质量图像修复工具

- 6 美图大模型发布!一口气上新7款产品,股价暴涨21.28%

- 7 厦门大学DeepSeek大模型系列报告

- 8 RLAMA:开源的本地文档问答工具,可高效管理和检索文档

- 9 Awesome CursorRules:收集和整理各种增强Cursor的优质cursorrules文件

- 10 3w+星标项目大佬创业:树莓派即可运行大模型,已获GitHub前CEO投资